近日,中国科学院上海天文台联合国内外科研机构,依托500米口径球面射电望远镜(FAST),在银河系一团超高速运动的星际气体云中,首次观测到了由超音速湍流主导的复杂丝状结构网络。这一成果为揭示星际介质在结构形成早期的演化机制提供了全新视角,相关成果于2025年7月16日在国际学术期刊《自然·天文学》(Nature Astronomy)在线发表。

这项研究的对象是一个被称作G165的极高速云(VHVC)。这是一团由氢原子组成的大质量气体云,距离地球约5万光年,位于远离银河盘面的高银纬区域,在银河系外围空间以每秒约300公里的速度高速运行。G165极高速云因其位置偏远、环境孤立,几乎不受恒星辐射与引力扰动等常见因素影响,成为研究星际云早期阶段的形成与演化的理想天然实验室。

FAST的超高灵敏度与空间分辨率使科学家得以揭示极高速云内部前所未有的结构细节。观测研究表明,G165气体云主要由暖中性介质组成,内部存在显著的超音速湍流运动,局部速度波动超过每秒20公里。常规高速云通常具有显著的冷暖气体混合特征,而G165则表现出截然不同的组成结构:其物质几乎完全由暖中性气体构成。这一显著差异表明以G165为代表的极高速云处于星际云演化过程中的更早期阶段。

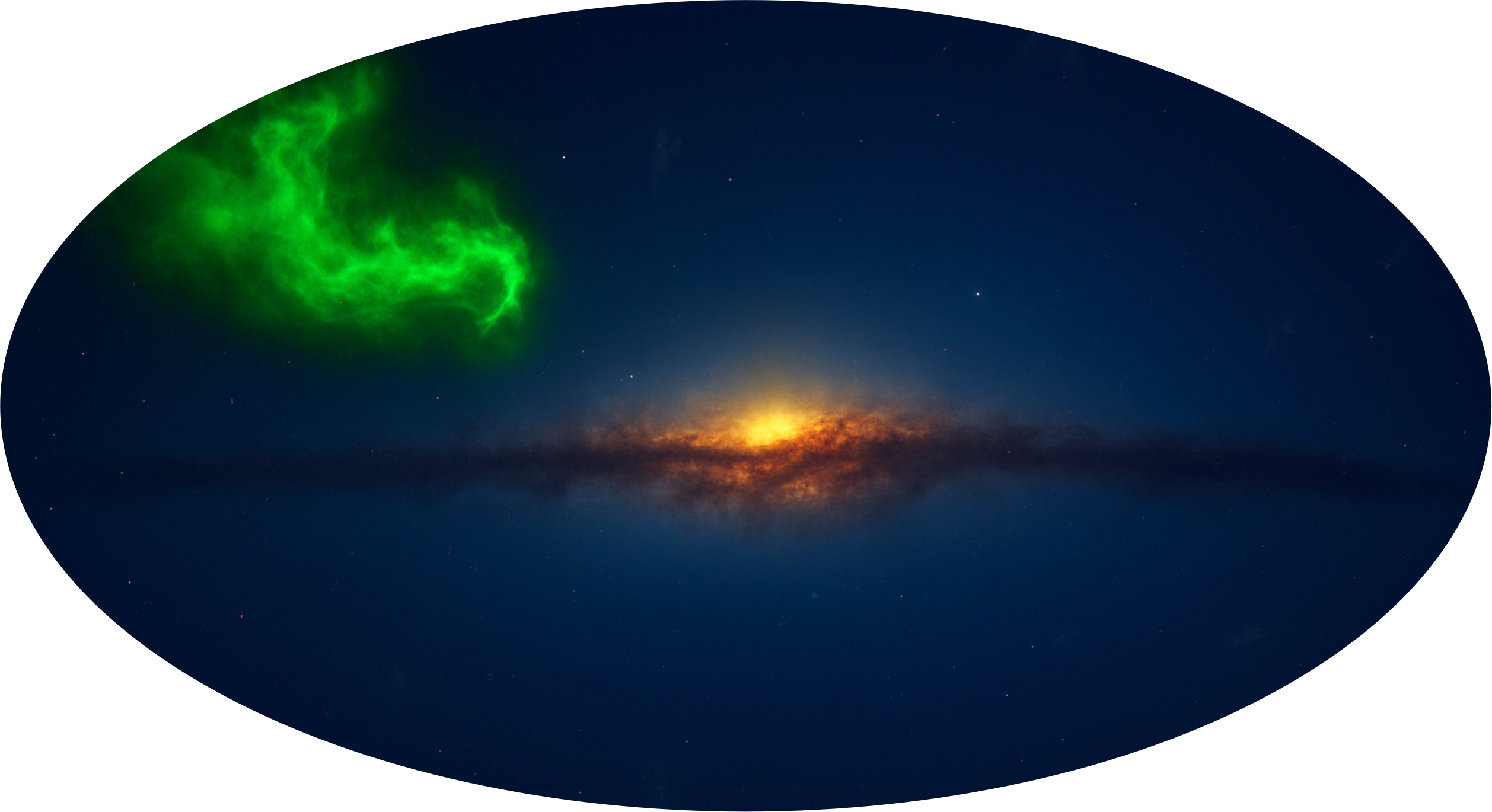

具有复杂内部结构的极高速云概念图

该研究通过FAST中性氢21厘米谱线观测,清晰地揭示出G165内部存在高度结构化的特征:其内部充满复杂交织的丝状结构,这些结构在多个速度层中形成网状分布。这些丝状体在三维空间中以扭曲形态相互交错,其径向密度剖面呈现显著不对称性。这一结构形态表明G165内部存在激波压缩过程,系统整体呈现出强烈的湍流特征。

该研究成果为揭示恒星形成区的物质来源与演化路径提供了新线索。科研团队未来将继续依托FAST望远镜,对更多极高速云开展系统观测,进一步探索星际结构形成的普适物理规律。

(一)

催化有均相催化、非均相催化、酶催化三种。我研究的不对称催化属于均相催化,使用的是手性催化剂。不对称催化的合成对象是手性化合物,这些化合物的分子有两个镜像异构体(也称手性异构体),就像人的左右手一样,看似相同,但不能重叠。不对称催化能够选择性地合成手性化合物的单一镜像异构体。

在我们常用的药物里,超过一半是手性药,这些药使用的是手性化合物单一镜像异构体。手性化合物的两个镜像异构体通常具有不同的生理活性,会对身体产生完全不同的影响。比如一种异构体对某种疾病有疗效,而另一种异构体无效,甚至更糟糕的情况是有时还有毒性。因此,合成手性药物必须是所需的镜像异构体,这时候就要用到不对称催化,它可以合成单一镜像异构体。

中国科学院院士、南开大学教授周其林。

不对称催化已经发展了半个多世纪,并且取得了辉煌的成就,其中关键性的突破是找到了有效的手性催化剂。第一个突破是发现了手性金属催化剂,这些催化剂大大加速了不对称催化的研究进程,许多手性化合物的单一镜像异构体都是用手性金属催化剂合成出来的。由于手性金属催化剂常常用到贵金属,而贵金属的储量有限,终有枯竭的一天。于是,化学家又找到了不使用金属的手性有机小分子催化剂,这是不对称催化领域的第二个突破。这两个工作都得到了诺贝尔化学奖。最近的发展趋势是利用生物催化剂来实现不对称催化,简单来讲,就是通过向“酶”学习或者改造“酶”,找到新的手性催化剂。

过去20多年里,我的工作重点是寻找一类高效、高选择性,并且能够广泛应用的手性催化剂。所谓高效,是指能以极少量催化剂实现反应,比如别人使用百分之一的催化剂,我们能否使用千分之一甚至万分之一的催化剂?而高选择性就是,别人合成单一镜像异构体做到了90%的选择性,我们能否做到99%的选择性?经过20多年的努力,我们终于找到了一类手性催化剂——手性螺环催化剂,这类催化剂在很多反应都达到了目前最高的效率和选择性,并且已经应用于数百个不对称合成反应和许多手性药物的合成。

(二)

做科研,最重要的是做真正有意义的事,不能只盯着发文章,否则会耽误一生,浪费才华。

化学研究的本质是创造新物质。评价化学研究成果的标准也应该是:是否创造出新物质,或者新方法和新理论?这些物质、方法和理论是否被他人广泛使用?也就是说,化学研究要发现真正的科学问题,并且解决这些问题,而不能将目光仅仅停留在发表论文上。倘若一味盯着发文章,几十年以后只留下了一堆文章,却没有留下任何自己发明的物质、方法和理论,这样的研究算不上真正的成功,顶多算是为期刊作了贡献。反之,如果专注于真正的科学问题,研究过程中自然会有成果产出,发文章也就水到渠成。

以有机合成为例,天然产物的合成极为复杂,对科研人员的综合素质要求极高。其设计合成路线并非线性推进,一条路线走不通就必须换另一条。假设合成目标分子需要50步反应,可能在20步时受阻,也可能在30步时卡壳,这时就得从头再来。这些合成步骤看上去是“白做”了,但是别忘了,前面走过的20步也好、30步也罢,只要是真正盯着科学问题做研究,其结果都值得发表。因为合成出从未有人制备过的中间体,本身就是有意义的阶段性成果。

如今,我国化学研究的水平已经进入了世界先进行列,但冒尖的创新还是较少,这是我们今后必须要突破的方向。创新思维并非到研究生阶段才形成,而是需要从基础教育入手培养。中学阶段是培养学生创新意识的最佳时期,要让他们自由畅想。如果我们现在不抓紧中学生的创新意识培养,也就不能期望20年以后有多少创新成果。我们要认识到这一问题的艰巨性——教育的意义不只是让孩子记住标准答案,更要引导他们思考:有没有第二种解法?有没有第三种思路?就像世界上没有 “包打天下” 的催化剂,尽管人类已发现众多催化剂,但仍有更多高效、高选择性的催化剂等待发掘。

近日,美国华盛顿大学与UW医学中心的跨学科研究团队联合开发出一款新型3D打印组织建模装置STOMP(Suspended Tissue Open Microfluidic Patterning),该装备的尺寸仅指尖般大小,结构紧凑、易于操作,能在实验室实现对复杂人类组织的更精确模拟,相关成果已发表于《Advanced Science》期刊。

新型3D打印组织建模装置STOMP

当前,3D组织工程已广泛用于多种疾病的疗法设计和测试,目标是构建尽可能接近体内细胞天然生长环境的实验条件。较常见的一种建模方式是将细胞悬浮在两根立柱之间的凝胶中,从而使得心脏、肺部、皮肤或肌肉骨骼等组织在其中生长,但此方法在同时研究多种组织类型时仍面临挑战。

STOMP装置在模拟神经肌肉类疾病涉及的复杂组织交界结构方面表现出色。其采用名为“铸型(casting)”的组织工程方法,研究人员将其比作在甜品模具中制作果冻。该装置的工作原理为毛细作用(类似吸管中的水上升现象),研究人员通过移液器将活性成分和合成材料构成的凝胶精准注入装置内微流控通道,可将不同类型的细胞均匀排布,如同在果冻中均匀撒入水果。该装置能在单个悬浮组织中划分多个独立区域,同时无需额外设备即可完成建模操作。

此次研究的通讯作者、华盛顿大学化学系教授Ashleigh Theberge表示,STOMP的开放性和灵活性将为组织工程和细胞信号传导等方向带来广阔的研究空间。“这是一个跨学科合作的成果,展示了科学家们如何共同打通物理工程与生物医学之间的壁垒。”

随着STOMP的推广,未来科研人员将能更方便地模拟骨、韧带、心肌等组织过渡区域,为探索复杂疾病机制及治疗策略提供工具基础。

近日,中国科学院脑科学与智能技术卓越创新中心联合复旦大学附属华山医院,与相关企业合作,成功开展了我国首例侵入式脑机接口的前瞻性临床试验。该成果标志着我国在侵入式脑机接口技术上成为全球第二个进入临床试验阶段的国家。

受试者是一位因高压电事故导致四肢截肢的男性。自2025年3月植入该脑机接口设备以来,系统运行稳定,仅用2—3周的训练,他便实现了下象棋、玩赛车游戏等功能,达到了跟普通人控制电脑触摸板相近的水平。未来,这一系统将有望为脊髓损伤、截肢等患者群体,通过运动功能替代技术实现生存质量改善。

全球最小尺寸、柔性最强的神经电极

△超柔性电极尺寸极小,仅约头发丝的1/100

中国科学院脑智卓越中心研制及生产的神经电极是目前全球最小尺寸、柔性最强的神经电极,让脑细胞几乎“意识”不到旁边有异物,最大程度上降低了对脑组织的损伤。该超柔性神经电极具备高密度、大范围、高通量、长时间的稳定在体神经信号采集能力,已相继完成在啮齿类、非人灵长类和人脑中长期植入和稳定记录验证,为植入式脑机接口前端电极组织相容性差和信道带宽窄的关键瓶颈提供了开拓性的解决方案。

全球最小尺寸的脑控植入体

△植入体直径26mm、厚度不到6mm,是全球最小尺寸的脑控植入体,仅硬币大小

在手术友好程度方面,脑智卓越中心研制的植入体直径26mm、厚度不到6mm,是全球最小尺寸的脑控植入体,仅硬币大小。因此不需要整体贯穿颅骨,只需要在大脑运动皮层上方的颅骨上“打薄”出一块硬币大小的凹槽用以镶嵌设备,再在凹槽中打一个在颅骨上开5毫米的穿刺孔。采用神经外科微创术式,在有效降低手术期风险的同时,显著缩短术后康复周期。

精准定位与植入

靶向大脑运动控制中心

△中国首例无线侵入式脑机接口系统前瞻性临床试验手术现场

精准定位和植入是整个手术成功的关键。高精度的电极植入可以为后续的信号采集和解码奠定重要基础。在为受试者进行手术前,华山医院采用了功能性核磁成像定位、人脑图谱绘制定位、受试者专属三维模型构建等多种脑功能定位方案绘制了患者大脑运动皮层的详细功能地图以确保植入位置的精确性。整个手术过程精确到毫米级别,最大限度地保证了安全性和有效性。

使用机械臂

拓展生活边界

下一步项目团队会尝试让受试者使用机械臂,使得他可以在物理生活中完成抓握、拿杯子等操作。后续还将涉及对复杂物理外设进行控制,例如对机器狗、具身智能机器人等智能代理设备的控制,拓展生活边界。

一款由“共和国勋章”获得者、广州国家实验室主任、中国工程院院士钟南山挂帅研发的国产原研药——昂拉地韦,近日获国家药监局批准上市,成为全球首个抗甲型流感PB2新药(作用于流感病毒RNA聚合酶的PB2亚基)。

全球每年有约10亿例流感病例,其中重症300万至500万例、死亡29万至65万例。冬春季节的流感流行季,对全球造成公共卫生负担。

过去,我国患者用以抵抗流感的药物,主要以进口药、仿制药为主。世界上使用最广泛的抗流感药奥司他韦,在我国抗流感药的销售额中占比超八成。但是,进口药不等价于优质药。奥司他韦进入我国已逾20年,有的病毒株已对其耐药。

今年5月20日,在单药头对头试验中胜过奥司他韦的昂拉地韦获国家药监局批准上市,为全球应对流感难题提供中国方案。

头对头试验,就是通过临床试验直接比较单用甲药和单用乙药的治疗效果。2023年7月,昂拉地韦与奥司他韦头对头试验的三期临床试验数据公布,昂拉地韦体现出多项优势。

“患者使用昂拉地韦后,既能快速缓解症状,又能在用药24小时内把病毒载量抑制得很低,不容易传染他人。同时,还不容易产生耐药性。”钟南山说。

《柳叶刀传染病》对昂拉地韦作出评价:抗流感病毒耐药的新疗法。昂拉地韦采用PB2新靶点,在病毒转录、复制的初始阶段就通过“抢帽”机制进行干扰,因此能对奥司他韦和玛巴洛沙韦的耐药株表现出强大抑制能力,同时还对禽流感病毒有效,能对抗人畜共患病。

昂拉地韦由广州国家实验室与广州医科大学附属第一医院、国家呼吸医学中心、国家呼吸系统疾病临床医学研究中心、广东众生睿创生物科技有限公司联合研发。作为呼吸系统疾病研究领域的国家战略科技力量,广州国家实验室全力践行新型举国体制,以“总平台、总链长”身份组织全国优势研究力量聚焦生命健康关键领域开展攻坚。

“谁有本事、有专长,就把谁集合起来一块干。国外同行很羡慕我们,能把力量集中起来办大事。”钟南山表示,昂拉地韦是国家实验室践行新型举国体制开展科技攻坚的样板。广州国家实验室已联合研发上市8款药物和疫苗,充分展现了我国科创能力,为实现高水平科技自立自强提供有力支撑。

早期地球生物多样性宏演化的空白。

“我们从哪里来,又要到哪里去?”

生命起源与演化,是国际顶级学术期刊《科学》(Science)曾列出的125个重大科学问题之一。

中国科学家最新发表的一项相关研究成果填补了早期地球生物多样性宏演化的空白,并为探索地外生命是否存在以及宜居地球的可持续发展提供了重要的理论基础和借鉴。

澎湃科技获悉,前述研究成果于12月20日凌晨在线发表在学术期刊《科学》(Science)上。该研究由南京大学地球科学与工程学院唐卿研究员和中国科学院院士沈树忠等科研人员与中外多家科研单位合作完成。

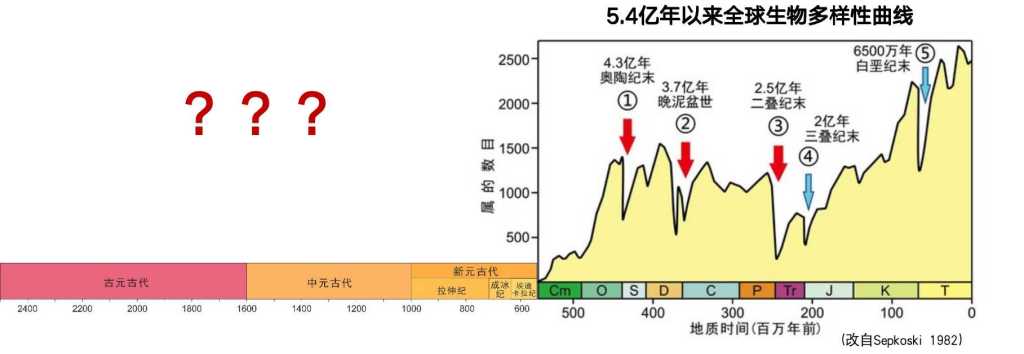

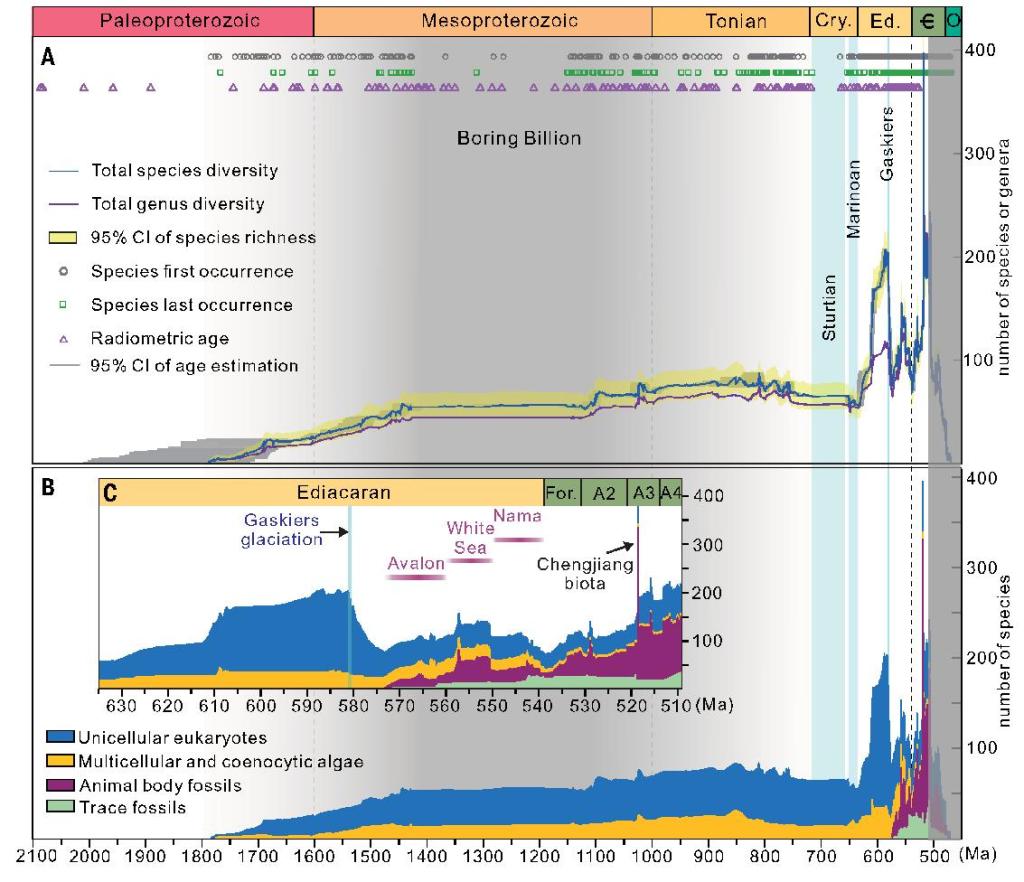

化石是记录生命演化的最直接证据。研究团队耗时六年时间创建了目前全球数据最全、信息量最大的早期地球古生物地层数据库、全球首个早期地球化石大数据平台,并采用“超算+AI”等分析方法,绘制出迄今第一条早期地球高精度生物多样性曲线,揭示了地球从20亿年前到5亿年前——约15亿年的高精度生物多样性演化历史。

早期地球高精度生物多样性曲线。

在新闻发布会上,唐卿研究员表示,未来如果有新的相关化石文献发表,将录入到前述数据库中,以更新其数据信息。

作为所有现代高等生物的祖先,早期生命是如何逢凶化吉,幸存,并演化至今的?

研究结果表明,随着第一个可信的真核生物化石在约17亿年前出现后,其多样性一直保持较低但稳定增长的模式。

直到约7.2亿年前全球性大冰期的出现,打断了生命演化的原有进程。

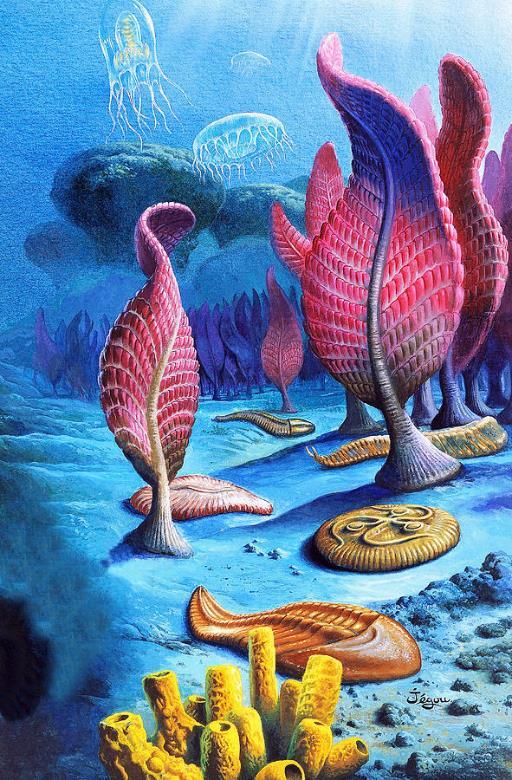

示意图:埃迪卡拉生物群。(Xiao and Laflamme 2009)

随着大冰期事件的结束,地球物种多样性开始迅速增加并且频繁发生波动,造成多次生物大辐射和大灭绝事件。其中包括约6.35亿年前到5.8亿年前的生物大辐射事件,以及紧随其后发生的生物演化史上第一次大灭绝事件,导致当时的优势类型—带刺的微体生物大量灭绝。

在此之后,形态更为复杂的宏体生物(包括动物)迎来了快速辐射。但这些复杂宏体生物在埃迪卡拉纪末(约5.51亿年前至5.39亿年前)又遭遇了两次明显的多样性下降,代表了动物演化史上最早的两次大灭绝事件。

该项研究首次用大数据方法定量化地揭示了早期地球15亿年的生命演化历程,定量勾画了复杂生命的起源、辐射、灭绝、再次辐射至现代生态系统形成的早期历史过程;也凸显了地表温度与氧气含量等环境因素的骤变对早期地球复杂生命系统演化的巨大影响,这对科学家探索极端环境下的地外生命和评估未来地球的宜居性提供了重要参考。

论文链接:science.org/doi/10.1126/science.adm9137

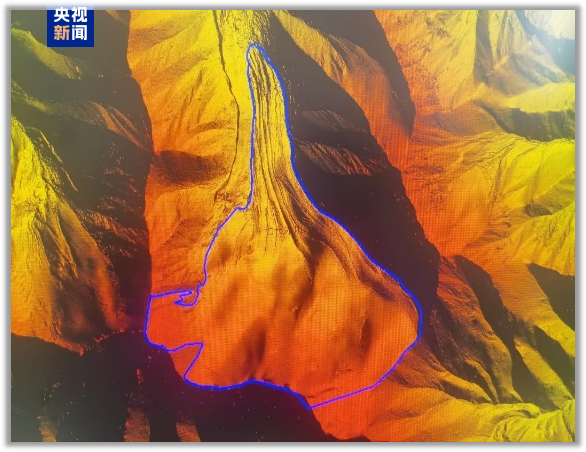

记者今天(12月20日)从中国科学院空天信息创新研究院获悉,近期,基于国家重大科技基础设施“航空遥感系统”建设的新舟60遥感飞机和奖状遥感飞机搭载航空冰雷达与三维激光雷达,在甘肃省老虎沟12号冰川、七一冰川、宁缠河3号冰川开展了冰川透视探测。这是我国首次基于航空冰雷达技术开展典型冰川储量调查,可以为河西走廊各流域水资源管理和决策、祁连山生态环境保护与区域可持续发展等提供关键数据支撑。

△七一冰川表面数字高程模型

本次调查自2024年9月至11月,共有效飞行13架次,采集原始数据5.6TB,取得了冰川表面数字高程模型(DEM)、冰川底部基岩数字高程模型(DEM)、冰川剖面图、冰川储量、冰川三维透视图及3个典型冰川储量等成果,并结合探地雷达(GPR)测量数据完成了冰川厚度准确度评价,圆满完成了项目各项任务。

至此,由中国科学院空天信息创新研究院航空遥感中心承担的“2024年度甘肃省典型冰川航空冰雷达透视探测项目”顺利通过验收。验收专家组给予项目高度评价,指出该项目首次实现了复杂地形条件下的复式山谷冰川冰厚测量,总体技术达到了国际领先水平。

航空冰雷达是一种搭载在飞机上对冰川进行透视观测的雷达,通过向冰川发射低频段电磁波,例如P波段或VHF波段,接收冰川表面和冰底基岩的散射回波,经过处理和反演得到冰川厚度及储量信息。

截至2月10日,上交所融资余额报9365.42亿元,较前一交易日增加85.06亿元;深交所融资余额报8887.41亿元,较前一交易日增加105.51亿元;两市合计18252.83亿元,较前一交易日增加190.57亿元。

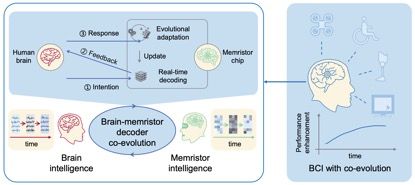

天津大学与清华大学联合研发出一款“双环路”脑机接口系统。此系统不仅精度更高、能耗更低,还能处理更为复杂的任务。

这款基于忆阻器神经形态器件的无创演进脑机接口系统,成功揭示了脑电发展与解码器演化在脑机交互过程中的协同增强效应,实现了人脑对无人机的高效四自由度操控。2月17日,这一成果在最新一期《自然·电子》上刊发。

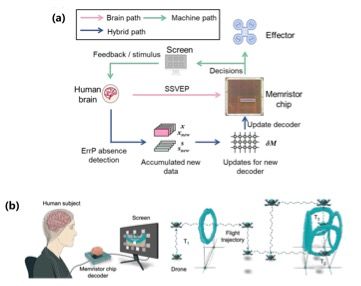

协同演进脑机接口框架。(联合研究团队供图)

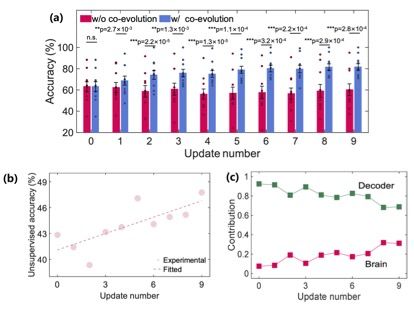

脑机接口能实现大脑与机器直接信息交流,促进生物智能与机器智能融合,被公认为是新一代人机交互和人机混合智能的核心技术。如何通过脑机之间的信息交互实现“互学习”,进而促进脑机智能的协同演进,是突破脑机性能瓶颈的重点和难点。但目前脑机交互过程中大脑与机器的动态耦合机制尚未厘清,导致脑机之间的长时程互适应能力较弱,工作性能随时间显著下降。

天津大学与清华大学的联合研究团队针对这一难题,发现脑电信号的非平稳特性与任务脑电演变密切相关。基于此,他们创新性地提出了“双环路脑机协同演进框架”,并通过忆阻器神经形态器件加以实现。在“双环路”框架下,脑与机的学习环路相互协同,共同促进系统性能的提升。

(a)脑-忆阻器交互式更新框架;(b)基于忆阻器脑电解码的实时脑控无人机飞行。(联合研究团队供图)

实验结果显示,新方案相较于传统方案,解码速度大幅提升,能耗显著降低。更令人瞩目的是,在连续6小时的长时程交互实验中,系统性能不仅保持稳定,准确率还提升了约20%。这一成果无疑为脑机接口技术的实用化奠定了坚实基础。

天津大学脑机海河实验室教授许敏鹏表示,这项研究不仅实现了生物智能与机器智能的互适应、互学习,还为未来脑机接口系统的发展提供了重要的理论基础与技术支撑。他透露,团队计划将这一系统拓展至更多便携式或可穿戴设备中,以满足不同场景下的智能人机交互需求。

(a)协同演进脑机解码正确率较初始状态提高20%;(b)任务相关脑电特征发生正向演化;(c)脑与忆阻器解码器实现互适应。(联合研究团队供图)

据了解,此研究由天津大学与清华大学团队合作开展:天津大学脑机海河实验室团队完成协同演进脑机接口软件系统设计与范式算法实现,清华大学集成电路学院团队完成协同演进忆阻器神经形态器件硬件设计及忆阻器算法设计部署。

近期,复旦大学附属华山医院郁金泰团队通过5年的临床和基础研究获得重大科研突破,在全球首次发现了帕金森病全新治疗靶点FAM171A2。此次研究发现的全新治疗靶点和候选新药有望从疾病早期对帕金森病进行干预,延缓疾病进展。相关研究成果于北京时间2月21日在线发表于国际学术期刊Science(《科学》)。

患病人数持续攀升 帕金森病成世界难题

帕金森病是仅次于阿尔茨海默病的第二常见的神经退行性疾病,严重影响患者日常生活。全球帕金森病患病人数预计将从2015年的700万左右增至2040年的1300万,我国帕金森病患者总数约占全球一半。传统药物和手术治疗都只是针对帕金森病的症状进行治疗,不能延缓疾病进展,因而进一步研究帕金森病致病的深层原因并开展针对性治疗,成为全球相关领域科学家竞相探索的战略高地。

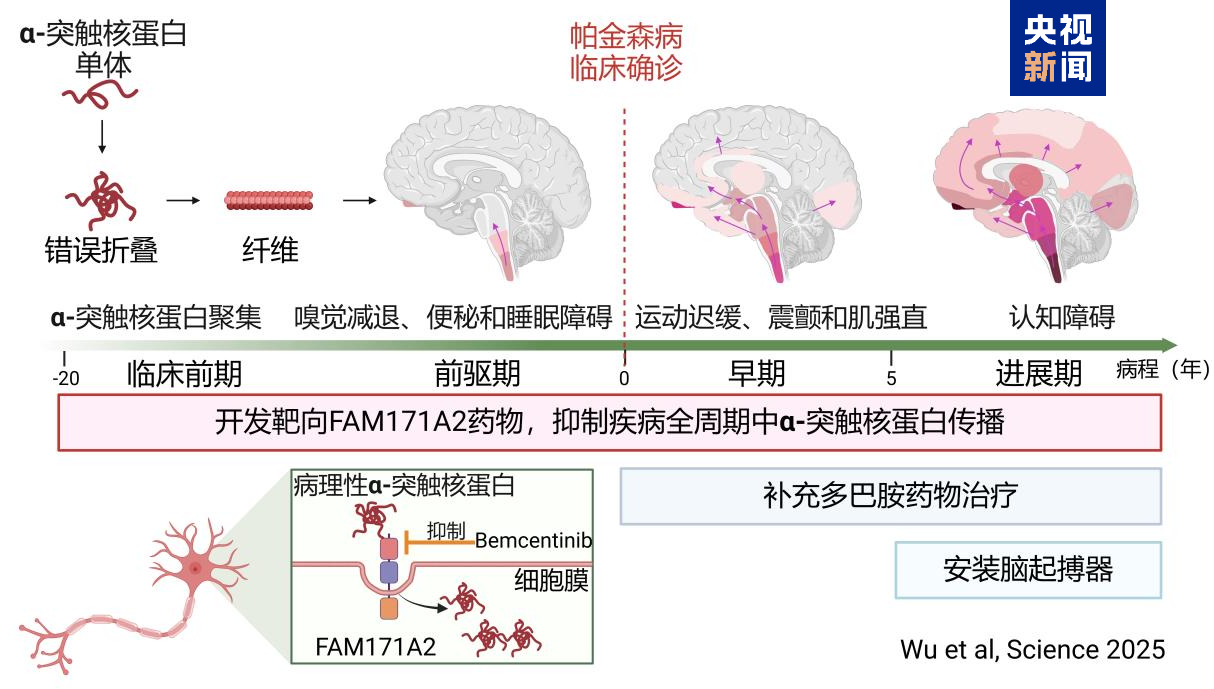

帕金森病病程进展机制及干预手段

全球首次发现FAM171A2靶点是病理性α-突触核蛋白传播的关键

复旦大学附属华山医院郁金泰团队通过长达5年的潜心钻研,明确了PD关键致病蛋白——病理性α-突触核蛋白在神经元间的传播“导火索”,并发现了抑制其传播过程的候选新药,为帕金森病治疗提供了新思路。

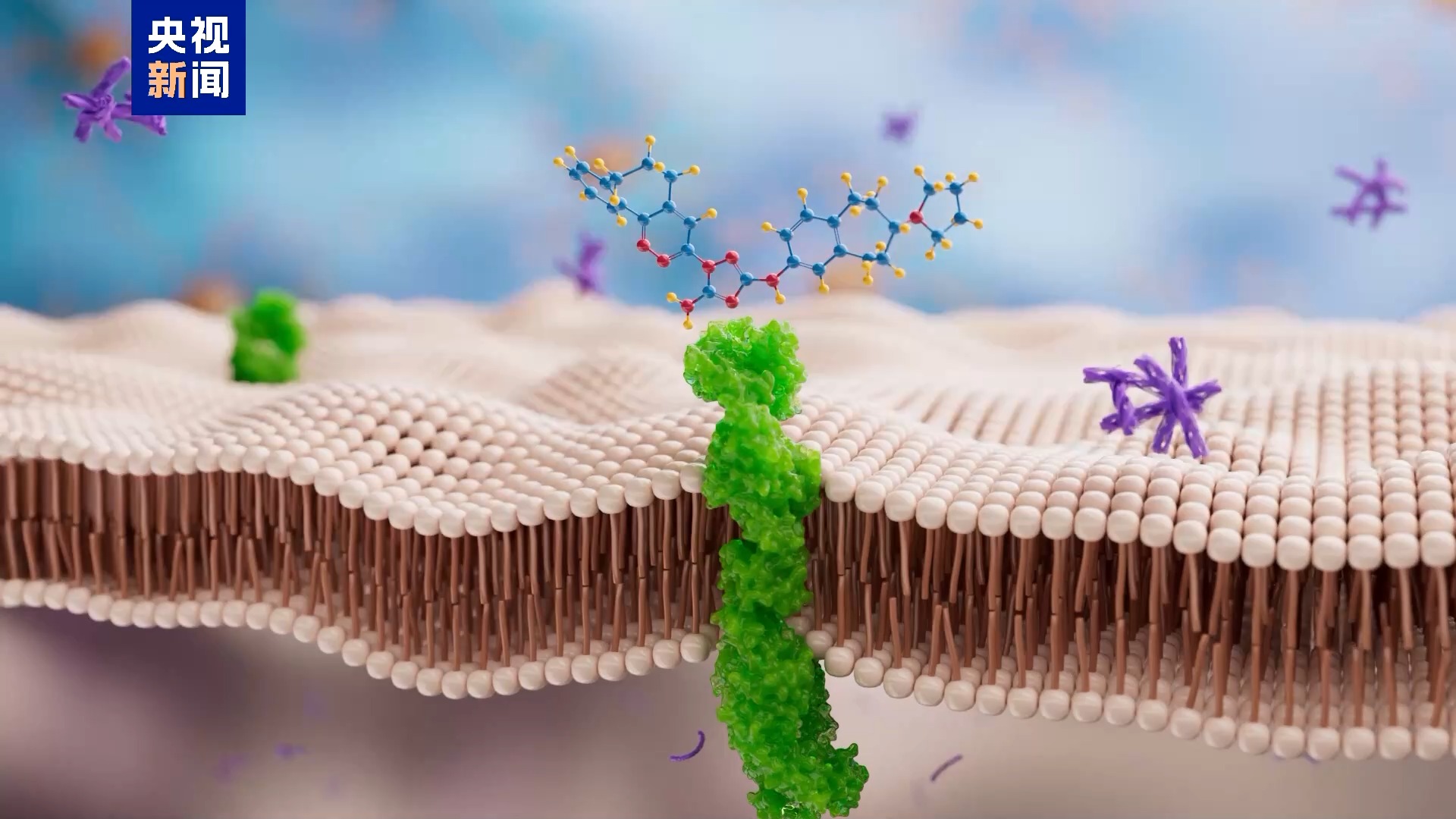

研究团队首先从大规模人群的全基因组关联分析中,发现FAM171A2是帕金森病风险基因,FAM171A2是一种神经元细胞膜蛋白,但其功能此前从未被人研究过。郁金泰团队经过系列研究证实了神经元膜受体FAM171A2蛋白是促进病理性α-突触核蛋白传播的关键,在全球首次揭示了FAM171A2蛋白与α-突触核蛋白的结合机制。

基于帕金森病患者临床样本分析,团队发现帕金森病患者大脑中FAM171A2蛋白含量增高,且FAM171A2含量越高的患者,其脑内病理性α-突触核蛋白含量也越高。紧接着,通过一系列体内外实验,研究团队发现在神经元细胞膜上,FAM171A2像“智能识别门”一样,可选择性地结合病理性α-突触核蛋白,并携带其进入到神经元中,诱导神经元内单体形式的α-突触核蛋白发生错误折叠,造成神经元死亡和其在神经元间的传播。随后,研究团队通过转基因动物证实,敲除小鼠神经元上FAM171A2,可以有效控制小鼠帕金森样症状的进展。

对于此次的研究发现,《科学》杂志审稿人指出,识别病理性α-突触核蛋白聚集体的神经元受体是帕金森病研究领域的“圣杯”,它能提供阻断病理传播并延缓疾病进展的治疗方法;该研究探讨了一个至关重要且具有重大意义的科学问题,是一项非常有趣、新颖、重要且具有转化意义的研究。

帕金森病患者在出现运动症状之前十几年,大脑内就已存在α-突触核蛋白病理,本次研究发现有望在疾病的临床前期、前驱期和临床期通过靶向抑制原创新靶点FAM171A2,阻断病理性α-突触核蛋白传播,延缓帕金森病进展。此外,开发靶向FAM171A2新药还可补充目前在临床期改善运动症状的补充多巴胺水平的药物治疗、在临床晚期用脑起搏器的神经调控治疗手段,构建更完善的帕金森病标本兼治的治疗新体系。

在这一成果基础上,郁金泰团队申请了基于干预FAM171A2治疗帕金森病的国际专利,接下来,将全面、系统地开展寻找治疗帕金森病的小分子药物、抗体以及基因治疗手段的临床前研发工作,并进一步将相关成果推向临床试验和临床应用。